Nel panorama digitale in continua espansione, in cui i dati vengono generati a una velocità senza precedenti, l’architettura dei database rappresenta il fondamento di una gestione efficiente dei dati. Con l’ascesa delle tecnologie Big Data e Cloud, insieme all’integrazione dell’Intelligenza Artificiale (AI), il regno delle architetture dei database ha subito una profonda trasformazione.

Questo articolo si addentra nell’intricato mondo delle architetture di database, esplorando il loro adattamento agli ambienti Big Data e Cloud e analizzando anche l’impatto in evoluzione dell’AI sulla loro struttura e funzionalità. L’importanza di architetture di database robuste diventa sempre più evidente. Dalle fondamenta tradizionali dei Relational Database Management Systems (RDBMS) alle soluzioni iper-flessibili offerte dai database NoSQL e alla scalabilità delle architetture basate su cloud, l’evoluzione continua a soddisfare le esigenze dell’attuale panorama basato sui dati.

Inoltre, la convergenza delle tecnologie AI introduce nuove dimensioni nella gestione dei database, consentendo l’ottimizzazione intelligente delle query, la manutenzione predittiva e l’emergere di database autonomi. Comprendere queste dinamiche è fondamentale per navigare nelle complessità degli ecosistemi di dati moderni e sfruttare il pieno potenziale delle informazioni basate sui dati.

La tradizione: database relazionali (RDBMS)

Tradizionalmente, i Relational Database Management Systems (RDBMS) sono stati i baluardi della gestione dei dati. Caratterizzati da dati strutturati organizzati in tabelle con schemi predefiniti, gli RDBMS garantiscono l’integrità dei dati e l’affidabilità transazionale tramite proprietà ACID (Atomicità, Consistenza, Isolamento, Durevolezza). Esempi di RDBMS includono MySQL, Oracle e PostgreSQL. Tradizionalmente, gli RDBMS scalano verticalmente, cioè aumentando la capacità del server su cui sono eseguiti (potenza di CPU, memoria, storage).

Inizialmente, gli RDBMS erano progettati per essere eseguiti su singole macchine. Con l’aumento dei requisiti di scalabilità e disponibilità, sono emersi RDBMS distribuiti e clustering, che distribuiscono il carico di lavoro su più server per migliorare le prestazioni e la disponibilità. Gli RDBMS sono stati adattati per funzionare nei contesti cloud. Servizi come Amazon RDS, Google Cloud SQL e Azure SQL Database offrono versioni gestite di RDBMS che possono scalare automaticamente e gestire l’infrastruttura sottostante. Molti RDBMS ora supportano strumenti e tecniche per l’analisi dei Big Data e l’integrazione con sistemi di analisi avanzati. Alcuni RDBMS hanno esteso le loro capacità per includere l’elaborazione in tempo reale e il supporto per dati non strutturati. Alcuni RDBMS moderni offrono supporto per più modelli di dati, come dati relazionali, documentali e grafici, all’interno dello stesso sistema. Questo approccio ibrido consente una maggiore flessibilità nella gestione dei dati.

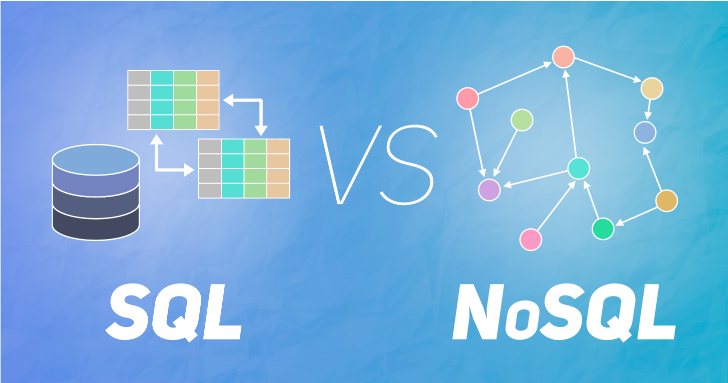

Abbracciare la complessità dei Big Data: database NoSQL

L’avvento dei Big Data ha reso necessario un passaggio dalle rigide strutture degli RDBMS a soluzioni più flessibili in grado di gestire enormi volumi di dati non strutturati o semi-strutturati. Entrano in gioco i database NoSQL, una famiglia di sistemi di database progettati per soddisfare la velocità, il volume e la varietà dei Big Data (Kaushik Kumar Patel 2024).

I database NoSQL si presentano in varie forme, tra cui archivi orientati ai documenti, archivi chiave-valore, archivi di famiglie di colonne e database grafici, ciascuno ottimizzato per modelli di dati e casi d’uso specifici.

- NoSQL: Database NoSQL (come MongoDB, Cassandra, e Couchbase) sono progettati per gestire dati non strutturati e semi-strutturati e per scalare orizzontalmente, permettendo una gestione più efficiente dei grandi volumi di dati.

- Hadoop: Un framework open-source per l’elaborazione distribuita di grandi volumi di dati attraverso cluster di macchine. Hadoop utilizza il paradigma MapReduce e un sistema di file distribuiti (HDFS).

- Spark: Un motore di elaborazione dati in memoria che offre prestazioni superiori rispetto a Hadoop per alcune applicazioni. Spark è progettato per elaborare grandi volumi di dati con bassa latenza.

Sfruttare la potenza del cloud: architetture di database basate su cloud

Le architetture di database basate su cloud sfruttano la scalabilità, la flessibilità e l’economicità dell’infrastruttura cloud per fornire accesso on-demand alle risorse di elaborazione e archiviazione dati.

Attraverso modelli quali Infrastructure as a Service (IaaS), Platform as a Service (PaaS) e Database as a Service (DBaaS), le organizzazioni possono scegliere il livello di astrazione e gestione più adatto alle proprie esigenze. Le architetture multi-cloud e cloud ibride migliorano ulteriormente la flessibilità consentendo la distribuzione del carico di lavoro su più provider cloud o l’integrazione con l’infrastruttura on-premise (Hichem Moulahoum, Faezeh Ghorbanizamani (2024)).

Esempi degni di nota includono Amazon Aurora, Google Cloud Spanner e Microsoft Azure Cosmos DB.

Flusso di dati e archiviazione: database locali vs. database cloud

Comprendere il flusso di dati e l’archiviazione è fondamentale per gestire efficacemente sia i database on-premise che quelli cloud.

Database locale

- Server applicativo: interagisce con il database, avviando la creazione, il recupero e gli aggiornamenti dei dati.

- Estrazione dei dati: questo processo, che spesso utilizza le metodologie ETL (Extract, Transform, Load) o ELT (Extract, Load, transform), estrae i dati da varie fonti, li trasforma in un formato compatibile con il database e li carica.

- Database: è la posizione di archiviazione principale, che gestisce e organizza i dati utilizzando strutture specifiche come tabelle relazionali o archivi di documenti NoSQL.

- Archiviazione: si tratta di dispositivi di archiviazione fisici, come unità disco rigido (HDD) o unità a stato solido (SSD), che contengono i file del database.

- Sistema di backup: i backup regolari sono fondamentali per il ripristino in caso di emergenza e per garantire la disponibilità dei dati.

Flusso di dati

- Le applicazioni interagiscono con il server del database, inviando richieste di creazione, recupero e aggiornamento dei dati.

- Il processo ETL/ELT estrae i dati da varie fonti, li trasforma e li carica nel database.

- I dati vengono mantenuti all’interno del motore del database e organizzati in base alla loro struttura specifica.

- I dispositivi di archiviazione contengono fisicamente i file del database.

- I backup vengono creati periodicamente e archiviati separatamente per scopi di recupero dei dati

Banca dati cloud

- Server applicativo: come nello scenario on-premise, interagisce con il database ma tramite un gateway API o un SDK fornito dal fornitore di servizi cloud.

- API Gateway/SDK: questo livello agisce come un’astrazione, nascondendo la complessità dell’infrastruttura sottostante e fornendo un modo standardizzato per le applicazioni di interagire con il database cloud.

- Database cloud: si tratta di un servizio gestito offerto dai provider cloud che gestisce automaticamente la creazione, la manutenzione e il ridimensionamento del database.

- Archiviazione cloud: rappresenta l’infrastruttura di archiviazione del provider cloud, in cui vengono archiviati i file del database e i backup.

Flusso di dati

- Le applicazioni interagiscono con il database cloud tramite il gateway API o SDK, inviando richieste di dati.

- Il gateway API/SDK traduce le richieste e interagisce con il servizio di database cloud.

- Il servizio di database cloud gestisce la persistenza, l’organizzazione e il recupero dei dati.

- I dati vengono archiviati nell’infrastruttura di archiviazione del provider cloud.

Differenze chiave

- Gestione: i database on-premise richiedono competenze interne per l’installazione, la configurazione, la manutenzione e i backup. I database cloud sono servizi gestiti, con il provider che gestisce questi aspetti, liberando risorse IT.

- Scalabilità: i database locali richiedono il ridimensionamento manuale delle risorse hardware, mentre i database cloud offrono un ridimensionamento elastico, adattandosi automaticamente per soddisfare esigenze mutevoli.

- Sicurezza: entrambe le opzioni richiedono misure di sicurezza come controllo degli accessi e crittografia. Tuttavia, i provider cloud spesso hanno una solida infrastruttura di sicurezza e certificazioni di conformità.

La convergenza delle architetture AI e database

L’integrazione dell’intelligenza artificiale nelle architetture dei database annuncia una nuova era di soluzioni di gestione dei dati intelligenti. Le tecnologie di IA come l’apprendimento automatico e l’elaborazione del linguaggio naturale aumentano la funzionalità del database consentendo analisi dei dati automatizzate, previsioni e processi decisionali. Questi progressi non solo semplificano le operazioni, ma aprono anche nuove strade per ottimizzare le prestazioni e l’affidabilità del database.

Ottimizzazione intelligente delle query

Nel regno dell’ottimizzazione intelligente delle query, le tecniche basate sull’intelligenza artificiale rivoluzionano il modo in cui i database gestiscono le query complesse. Analizzando i modelli di carico di lavoro e le risorse di sistema in tempo reale, gli algoritmi di intelligenza artificiale regolano dinamicamente i piani di esecuzione delle query per migliorare l’efficienza e ridurre al minimo la latenza. Questo approccio proattivo garantisce prestazioni ottimali, anche di fronte a carichi di lavoro fluttuanti e strutture dati in evoluzione.

Manutenzione predittiva

La manutenzione predittiva, potenziata dall’intelligenza artificiale, trasforma il modo in cui le organizzazioni gestiscono la salute e la stabilità del database. Sfruttando dati storici e analisi predittive, gli algoritmi di intelligenza artificiale prevedono potenziali guasti del sistema o colli di bottiglia delle prestazioni prima che si verifichino. Questa lungimiranza consente strategie di manutenzione proattive, come l’allocazione delle risorse e gli aggiornamenti del sistema, la riduzione dei tempi di inattività e l’ottimizzazione dell’affidabilità del database.

Basi di dati autonome

I database autonomi rappresentano l’apice dell’innovazione basata sull’intelligenza artificiale nelle architetture dei database. Questi sistemi sfruttano gli algoritmi di intelligenza artificiale per automatizzare le attività di routine, tra cui l’ottimizzazione delle prestazioni, la gestione della sicurezza e i backup dei dati. Ottimizzando autonomamente le configurazioni del database e affrontando le vulnerabilità della sicurezza in tempo reale, i database autonomi riducono al minimo il sovraccarico operativo e migliorano l’affidabilità del sistema. Questa nuova autonomia consente alle organizzazioni di concentrarsi su iniziative strategiche anziché su attività di manutenzione di routine, guidando l’innovazione e l’efficienza in tutta l’azienda.

Uno sguardo al futuro: tendenze e sfide

Con l’evolversi della traiettoria delle architetture dei database, una serie di tendenze e sfide attirano la nostra attenzione:

Elaborazione dei dati al limite

La proliferazione dei dispositivi Internet of Things (IoT) e l’ascesa delle architetture di edge computing annunciano un passaggio verso l’elaborazione decentralizzata dei dati. Ciò richiede lo sviluppo di soluzioni di database distribuite in grado di gestire e analizzare in modo efficiente i dati all’edge della rete, ottimizzando la latenza e l’utilizzo della larghezza di banda, garantendo al contempo informazioni in tempo reale e reattività.

Privacy e sicurezza dei dati

In un’epoca di volumi di dati in rapida crescita, la salvaguardia della privacy e della sicurezza dei dati assume un’importanza fondamentale (Jonny Bairstow, (2024)). Man mano che i quadri normativi si inaspriscono e le minacce informatiche aumentano, le organizzazioni devono orientarsi nell’intricato panorama della governance dei dati per garantire la conformità a rigide normative e rafforzare le difese contro le vulnerabilità della sicurezza in continua evoluzione, salvaguardando le informazioni sensibili da violazioni e accessi non autorizzati.

Gestione dei dati federati

La proliferazione di fonti di dati eterogenee su sistemi e piattaforme diversi sottolinea la necessità di soluzioni di gestione dei dati federate. Le architetture di database federate offrono un framework coeso per un’integrazione e un accesso senza soluzione di continuità alle fonti di dati distribuite, facilitando l’interoperabilità e consentendo alle organizzazioni di sfruttare l’intero spettro delle proprie risorse di dati per un processo decisionale informato e approfondimenti fruibili.

Database quantistici

L’avvento del quantum computing annuncia cambiamenti di paradigma nelle architetture dei database, promettendo balzi esponenziali nella potenza di calcolo e nell’efficienza algoritmica. I database quantistici, sfruttando i principi della meccanica quantistica, hanno il potenziale per rivoluzionare l’elaborazione dei dati consentendo calcoli più rapidi e analisi più sofisticate per set di dati complessi. Con la maturazione del quantum computing, le organizzazioni devono prepararsi ad abbracciare queste capacità trasformative, sfruttando i database quantistici per sbloccare nuove frontiere nell’innovazione e nella scoperta basate sui dati.